“자해 방법은…” 이런 AI 규제하는 미국, 기업에 맡긴 한국

━

청소년 안전 위협하는 AI

지난 11일(현지시간) 미국 캘리포니아주 의회에선 ‘AI 친구’ 챗봇을 규제하는 미국 최초의 법안(SB243)이 통과됐다. 마지막 단계인 개빈 뉴섬 캘리포니아 주지사의 서명을 받을 경우 2026년 1월부터 시행될 예정이다. 법안은 AI 챗봇 운영회사에 미성년자를 보호할 안전 장치를 마련할 의무를 부여한다. 미성년자에게 3시간마다 AI와 대화하고 있다는 알림을 주고, 성적인 콘텐트 노출을 막는 내용이 포함됐다. 하루 뒤인 12일엔 미 연방거래위원회(FTC)가 AI 친구 챗봇을 제공하는 오픈AI, 메타, 구글, xAI 등 7개 기업에 대한 조사에 착수해 관련 자료 제출 요청했다. FTC는 아동·청소년과 AI의 상호작용을 기업이 어떻게 모니터링하는지, 챗봇의 성적인 주제에 대한 답변 빈도와 청소년들의 접근을 어떻게 제한하고 있는지에 대해 질의했다.

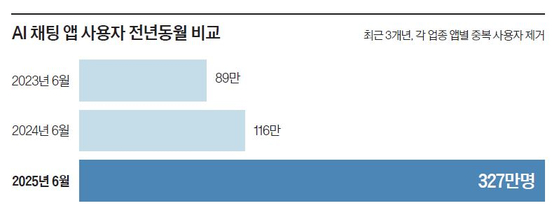

최근 한국에서도 AI 친구 챗봇이 청소년 층을 중심으로 유행하고 있다. 그러나 챗봇에 대한 정부나 당국 차원 안전 가이드라인·규제가 없어 기업 자체 기준에 의존하고 있어 한계가 있다. AI 채팅 앱 국내 선두주자인 스캐터랩(제타)과 뤼튼(크랙) 등은 최근 일종의 ‘성인 모드’를 만들어 선정적 설정의 AI 캐릭터와 대화에 미성년자가 노출되지 않게 제한을 두고 있다. 네이버·LG AI연구원 등도 공격 상황을 가정해 시스템에 침투하는 ‘레드팀’을 만들어 취약점을 찾고 적절한 조치를 취하는 필터링을 한다. 김명주 AI안전연구소장은 “생성AI 모델은 미성년 이용자 고려 없이 애초부터 성인 대상으로 설계, 개발됐기 때문에 이런 문제가 야기될 수밖에 없다”면서 “시간이 걸리더라도 사회적 수준의 가이드라인이 필요한 상황”이라고 말했다.

김민정([email protected])