[강광우의 혁신창업의 길] 엔비디아 GPU보다 5배 빠른 LPU로 150조원 시장 공략

[연중 기획 혁신창업의 길] R&D 패러독스 극복하자 〈93〉 김주영 하이퍼엑셀 대표

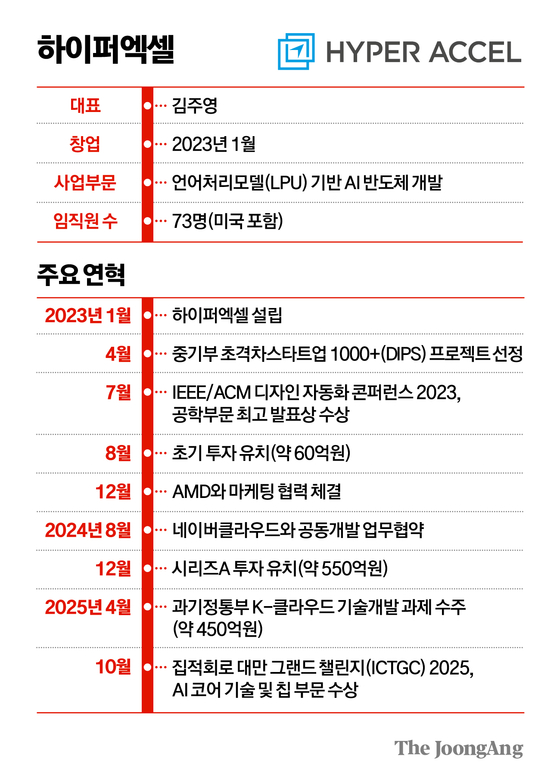

마이크로소프트(MS) 반도체 엔지니어, KAIST 교수에서 창업가로 변신한 김주영 대표가 이끄는 하이퍼엑셀이 대표적인 기업이다. 하이퍼엑셀은 거대언어모델(LLM) 추론에 특화한 AI 반도체인 ‘언어처리장치(LPU)’를 세계 최초로 개발해 내년 초 양산에 돌입한다. 추론 영역에선 GPU보다 처리 속도가 5배 빠른 데다 비용·전력 사용 측면에서도 강점을 가지고 있다. 탄탄한 기술력 덕분에 AMD의 개발 및 마케팅 협업 제안을 받았고, 창업 2년도 안 돼 610억원 투자 유치도 성공했다. 지난 9월엔 KAIST에서 열린 ‘혁신창업국가 대한민국 국제포럼’에서 산업통상자원부 장관상을 받았다. 지난달 29일 서울 서초구의 하이퍼엑셀 본사를 찾아 김 대표를 만났다.

추론에 최적화된 AI 반도체

비용·전력 효율성도 GPU 압도

창업 2년 만에 610억 투자 유치

2028년까지 매출 1000억 목표

비용·전력 효율성도 GPU 압도

창업 2년 만에 610억 투자 유치

2028년까지 매출 1000억 목표

Q : LPU가 뭔가.

A : “챗GPT 등 생성 AI 서비스의 기반이 되는 LLM 추론에 최적화한 AI 반도체다. GPU는 탁월한 병렬 연산 능력 덕분에 AI 모델이 대규모 데이터를 학습할 때 굉장히 효과적인 수단이다. 하지만 학습 데이터를 활용해 답을 내는 과정인 추론 영역에서는 비효율적이다. GPU의 장점인 병렬 연산이 추론 단계의 특정 과정과 잘 맞지 않아서다. 이 때문에 GPU는 추론 단계에선 실제 가진 능력을 50%도 발휘하지 못한다. 고가의 GPU를 제대로 활용하지 못하는 문제를 해결하기 위해 나온 게 일반 추론에 특화된 신경망처리장치(NPU)다. LPU는 NPU에서 분화해 LLM 추론에 더 집중한 칩이다.”

Q : GPU와 성능 차이는.

A : “내년에 양산할 LPU는 생성 AI 모델이 1초 동안 처리할 수 있는 ‘토큰’ 양을 나타내는 TPS(Tokens per Second)가 GPU 대비 5배 높을 것으로 기대된다. 토큰은 LLM이 인식할 수 있는 가장 작은 단위다. TPS가 높다는 건 그만큼 AI 모델의 답변이 빠르게 생성된다는 것을 의미한다. 비용과 전력 효율성(비용과 전력 사용량 대비 성능) 측면에서도 GPU를 압도한다. 엔비디아 GPU H100과 비교해 비용 효율성은 20배, 전력 효율성은 5배 이상 높다.”

Q : 주로 어떤 고객이 LPU를 찾나.

A : “네이버클라우드처럼 AI 데이터센터를 운영하는 클라우드 서비스 제공사(CSP)가 가장 큰 고객이다. 해외 유명 테크 기업들과도 사전검증과정(PoC)이 예정돼 있다. 이들은 앞으로 추론 서비스에 대한 컴퓨팅 용량을 늘려나가야 하는데, GPU는 가격과 전력 측면에서 감당하기 힘들어 LPU를 찾고 있다.”

Q : 엔비디아와 경쟁이 가능할까.

A : “GPU와 경쟁하기보단 공생하려고 한다. LPU는 GPU의 대체재라기보다 보완재에 가깝다. GPU는 AI 모델 학습뿐 아니라 추론 시장에서도 글로벌 점유율이 95%에 달할 정도로 시장 선호도가 높다. 하지만 최근 고객사들은 AI 데이터센터에 GPU와 함께 ‘가성비(가격 대비 성능)’ 있는 AI 반도체를 최적의 조합으로 섞어 쓰는 반도체 믹스 전략을 구상하고 있다. 우리가 파고들 틈새시장이다. 2032년까지 약 150조원으로 성장할 것으로 예상되는 추론 시장에서 이런 고객들을 1%만 확보해도 규모가 1조 5000억원에 이른다.”

딥테크 창업, 기술이 100% 아니다

Q : 왜 창업을 생각했나.

A : “2010년부터 9년간 MS 반도체 엔지니어로 일하다 2019년 한국으로 돌아와 KAIST 전기및전자공학부 교수로 일했다. 그 당시 ‘트랜스포머 모델’(챗GPT의 기반이 된 자연어 처리 모델)이 AI 개발의 혁신을 가져오고 있었다. 큰 기술적 변화를 접하며 트랜스포머 모델을 가속할 수 있는 AI 반도체인 LPU 연구에 매진했다. 연구 결과를 2021년 글로벌 반도체 학회인 ‘핫 칩스’에서 최초로 발표했다. AMD가 이 연구 성과를 알아보고 협업을 요청해왔다. 이를 계기로 시제품을 개발하고 있었는데 이듬해 말 오픈AI가 챗GPT를 내놓았다. 이 기회를 놓쳐선 안 되겠다고 생각해 2023년 창업에 뛰어들었다.”

Q : 창업해보니 어려운 점은.

A : “창업 전까지 기술 개발만 해왔다. 기술이 전부라고 생각했다. 막상 창업해보니 창업을 성공적으로 이끄는 데 기술은 25~35% 비중밖에 안 되더라. 딥테크(deep-tech·첨단 기반 기술로 승부하는 기술집약형) 스타트업이기 때문에 여전히 기술이 제일 중요한 기둥이지만, 그 외 투자 유치와 홍보, 자금 운용, 마케팅 등 익숙하지 않은 영역에서 극복해야 할 과제가 많다. 새 기술을 개발하는 것과 시장에서 제품 가치를 창출하는 건 굉장히 달랐다. 이를 보완하기 위해선 창업자가 직접 할 수 없는 영역에서 전문가들을 영입해 팀을 구성하는 게 중요하다.”

창업 3년 만에 제품 양산

Q : 첫 양산은 언제 시작하나.

A : “삼성전자 파운드리 4나노 공정 기술이 적용된 LPU 제품인 ‘베르다(Bertha)’가 내년 1분기 양산에 들어간다. 교수 시절부터 핵심 기술을 개발한 뒤 창업해 3년 만에 양산 단계까지 올 수 있었다.”

Q : 현재 매출은.

A : “양산이 시작되고 생산 규모가 늘어야 이익이 돌아온다. 2028년 안에 매출 1000억원을 달성하고, 흑자 전환하는 게 목표다. 흑자전환까지 자본도 충분하다. 운 좋게 지금까지 610억원의 벤처캐피털(VC) 투자를 유치했고, 450억원 규모 정부 과제도 수주했다. 기술력을 기반으로 한 지식재산권(IP) 매출도 발생하는 상황이다.”

Q : LPU 이후 계획하는 프로젝트는.

A : “우리 기술의 특징은 레고 블록처럼 모듈화돼 있다는 점이다. 덕분에 새로운 제품 개발에도 유연하게 대처할 수 있다. 피지컬 AI 기반이 되는 VLA 모델(시간-언어-행동 모델)에 특화한 칩도 개발 중이다. 내년 4분기에는 휴머노이드에 활용할 수 있는 온 디바이스(기기 내장형) 시제품도 나올 예정이다. 한국은 반도체 제조부터 후공정·시스템·서비스까지 내부 생태계에서 모든 게 가능한 국가다. 국내에서 만들고 증명해서 글로벌 시장에 도전할 거다.”

이광형 KAIST 총장

박기호 LB인베스트먼트 대표

◆‘혁신창업의 길’에서 소개하는 스타트업은 ‘혁신창업 대한민국(SNK) 포럼’의 추천위원회를 통해 선정합니다. SNK포럼은 중앙일보ㆍ서울대ㆍKAIST를 중심으로, 혁신 딥테크(deep-tech) 창업 생태계 구성원들이 함께 참여하는 단체입니다. 대한민국이 ‘R&D 패러독스’를 극복하고, 퍼스트 무버 국가로 도약하기 위해서는 연구개발(R&D)에 기반한 기술사업화(창업 또는 기술 이전)가 활성화되어야 한다는 취지입니다.

강광우([email protected])