‘국가대표 AI’ 선정 사업에 참여 중인 업스테이지가 자체 개발한 거대언어모델(LLM) ‘솔라 오픈 100B(솔라 오픈)’를 오픈소스로 공개했다. 업스테이지는 데이터 학습 등 초기 단계부터 독자적으로 AI모델을 구축하는 ‘프롬 스크래치(from scratch)’ 방식을 강조하면서, 세부 내용을 담은 테크 리포트도 함께 발표했다.

━

무슨 일이야

업스테이지는 솔라 오픈을 글로벌 오픈소스 플랫폼 ‘허깅페이스’에 공개했다고 6일 밝혔다. 솔라 오픈은 과학기술정보통신부 ‘독자 AI 파운데이션 모델 프로젝트’의 첫 번째 결과물이다. 회사 측에 따르면 솔라 오픈은 중국의 대표 AI 모델인 ‘딥시크 R1’에 비해 사이즈는 15%에 불과하지만, 주요 벤치마크 평가에서 한국어(110%)·영어(103%)·일본어(106%) 등 딥시크보다 앞선 성능을 보였다고 했다. 다만 해당 모델은 지난해 5월 출시된 모델이다.

━

이게 왜 중요해

업스테이지는 이번에 공개한 모델이 한국어 능력에서 특히 강점이 있다고 강조했다. 한국 문화 이해도(Hae-Rae v1.1), 한국어 지식(CLIcK) 등 주요 한국어 벤치마크 결과 딥시크 R1 대비 2배 이상의 성능 격차를 보였다. 이는 한국어 데이터 부족을 해결하기 위해 다양한 합성 데이터와 분야별 특화 데이터를 학습에 활용하고, 필터링 방법론을 고도화한 결과라는 설명이다. 업스테이지는 이 데이터셋의 일부를 한국지능정보사회진흥원(NIA)의 ‘AI 허브’를 통해 개방할 계획이라고 밝혔다.

업스테이지가 참여 중인 정부의 독자 파운데이션 모델 선정 사업은 ‘소버린 AI’를 표방하고 있다. 이미 있는 모델을 파인 튜닝(미세조정)하는 방식이 아니라, 해외 기술에 의존하지 않는 독자적인 AI 모델을 개발해야 한다는 의미다. 김성훈 업스테이지 대표는 “솔라 오픈은 업스테이지가 처음부터 독자적으로 학습해낸 모델”이라고 강조했다.

━

더 알면 좋은 것

앞서 솔라 오픈은 ‘중국 AI 스타트업 즈푸AI의 AI 모델 GLM을 기반으로 만들어졌다’는 도용 논란을 겪었다. 이에 김 대표는 지난 2일 공개 검증회를 열고 솔라 오픈의 모델 가중치와 로스(오답률) 그래프 등을 공개했다. 이후 의혹 제기자가 공개적으로 사과하면서 논란은 일단락됐다.

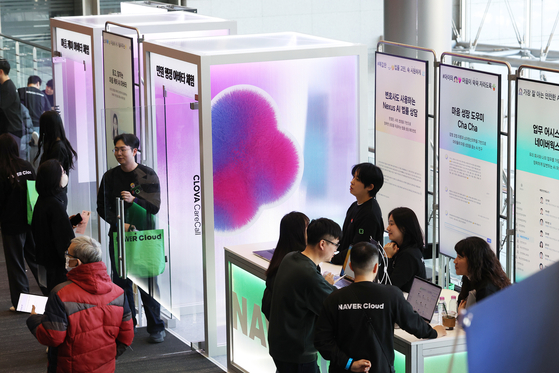

하지만 업계에선 AI 모델의 독자성에 관한 논란은 사그러들지 않고 있다. 정부가 사업 기준으로 삼은 ‘프롬 스크래치’의 개념이 모호해서다. 이날 업계에선 네이버클라우드가 독자 AI 파운데이션 모델로 개발 중인 ‘하이퍼클로바X 시드 32B 싱크’ 모델이 중국 알리바바의 큐웬 2.4 언어모델의 비전·오디오 인코더(외부 정보를 모델이 이해할 수 있는 신호로 변환하는 역할)를 파인 튜닝해 썼다는 주장이 나왔다.

이에 대해 네이버클라우드 측은 “글로벌 기술 생태계와의 호환성, 전체 시스템의 효율적 최적화를 고려해 검증된 외부 인코더를 전략적으로 채택했다”며 “이는 기술적 자립도가 부족해서가 아니라, 이미 표준화된 고성능 모듈을 활용해 전체 모델의 완성도와 안정성을 높이기 위한 고도의 엔지니어링 판단”이라고 해명했다.

서지원([email protected])